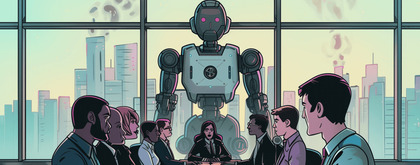

Hoe om te gaan met de risico's van AI in jouw bedrijf

De snelheid waarmee we nieuwe AI-tools implementeren op onze werkplek is enorm hoog. Vooral de adoptiecurve van Gen-AI toont een van de hoogste technologie-adoptie snelheden ooit. De hoge snelheid waarop nieuwe AI-diensten op de markt komen, kunnen bij besluitvormers voor over-enthousiasme of juist een FOMO-gevoel zorgen, waardoor ze de risico's voor hun bedrijf, team en klanten misschien over het hoofd zien.

Een heel handige toepassing van nieuwe AI-tools is bijvoorbeeld het geautomatiseerd notuleren van je vergaderingen. Je kunt door AI aantekeningen laten maken, acties laten noteren en samenvattingen laten maken, ook als je zelf niet bij de vergadering aanwezig bent. Je kan zo van je vergaderingen gedetailleerde transcripties krijgen, zodat je altijd in je transcripties kunt zoeken naar wat er tijdens die vergadering is afgesproken. Geweldig. Waarom zou je deze transcripties niet ook meteen gebruiken om door AI mogelijke fraude te laten opsporen? Alle digitale vergaderingen kunnen immers worden opgenomen en geanalyseerd. Als werknemers iets dubieus hebben besproken, kun je automatisch een melding krijgen en exact nagaan wat ze hebben besproken. Dit is geen fictief voorbeeld. Microsoft biedt deze dienst al aan als onderdeel van hun Copilot for Security. Het voorbeeld dat Microsoft gebruikt gaat over mogelijke aandelenfraude. En ja, dat wil je voorkomen, maar wat zou nog meer op deze manier kunnen worden gecontroleerd?

Onvoorziene effecten van het gebruik van AI in bedrijven

Dit voorbeeld klinkt op het eerste gezicht misschien interessant vanuit een zakelijk of juridisch perspectief, maar hoe zal dit je team op de lange termijn beïnvloeden? Als je teamleden weten dat alles wat ze zeggen wordt opgenomen en geanalyseerd, zullen ze misschien anders met elkaar omgaan. Zullen ze tijdens vergaderingen nog steeds een grapje of een sarcastische opmerking durven te maken? Kunnen ze nog steeds goede relaties met elkaar opbouwen, of zullen ze privéonderwerpen vermijden om te voorkomen dat hun privéleven wordt vastgelegd in de transcripties? Zullen ze bang worden om kritiek te leveren op (slecht) bedrijfsbeleid? Als er geen persoonlijke relaties zijn tussen teamleden en als de vrijheid van meningsuiting verdwijnt, hoe zal het team dan presteren?

Dit is een extreem, maar wel een realistisch voorbeeld. Het product is al op de markt. Maar er zijn meer AI-gerelateerde risico’s voor je bedrijf. Door AI gegenereerde content is vaak nog van lagere kwaliteit dan content die door experts of creatieve geesten is gemaakt. Feitelijke fouten en (discriminerende) stereotypen in gegenereerde content kunnen je reputatie schaden. Het gebruik van AI ter vervanging van klantenservice kan kosten besparen, maar verhoogt het ook de snelheid en kwaliteit van ondersteuning aan je klant, of werpt het alleen maar een extra barrière op om contact met de klant te vermijden. AI-productiviteitstools gebruiken betekent vaak dat je (vertrouwelijke) gegevens deelt met die AI-tools. Sommige tools kunnen jouw gegevens gebruiken om hun eigen AI-modellen te trainen, en op die manier bestaat er een (theoretische) kans dat andere gebruikers, of zelfs concurrenten, toegang krijgen tot jouw gegevens.

Basisregels voor het gebruik van AI-tools

Bij SST gebruiken we natuurlijk ook AI-tools. Onze software engineers worden ondersteund door een AI Copilot voor softwareontwikkeling. We gebruiken Gen-AI om content te genereren en we zijn actief op zoek naar nieuwe manieren om onze processen met behulp van AI nog verder te verbeteren. Om de risico's van deze AI-tools te beperken, hebben we drie basisregels en -maatregelen binnen SST ingevoerd:

- Zodra klantgegevens, broncode of andere gevoelige informatie wordt gebruikt, mogen we alleen gebruikmaken van vooraf goedgekeurde tools. Dit zijn tools die garanderen dat onze gegevens niet worden gebruikt voor trainingsdoeleinden en nooit kunnen worden gedeeld. We kopen licenties voor onze medewerkers zodat we de instellingen over gegevensgebruik op bedrijfsniveau kunnen beheren.

- We delen nooit persoonsgegevens of zeer gevoelige bedrijfsgegevens met externe AI-tools.

- Als teamleden Gen-AI gebruiken, moeten ze zelf alles controleren wat wordt gegenereerd en zijn ze zelf verantwoordelijk voor de content of code die wordt gegenereerd, net zoals ze dat zouden zijn als ze die inhoud zelf zouden maken.

Nuttige en veilige toepassing van AI

Bij SST ontwikkelen we voor onze klanten ook nuttige en veilige AI-oplossingen, bijvoorbeeld een tool die meerdere gescheiden kennisbanken in een bedrijf eenvoudiger toegankelijk maakt, een door machine learning aangedreven tool voor het maken van inschattingen en een AI chatbot die een juridische afdeling helpt bij het doorzoeken van eerdere zaken om vergelijkbare situaties en uitspraken te vinden. Hoewel we voor deze oplossingen vaak bestaande AI-modellen gebruiken, besteden we extra aandacht aan hoe de gegevens worden gebruikt en welke gebruikers toegang krijgen tot bepaalde informatie.

Natuurlijk heeft AI nog veel meer mogelijkheden en toepassingen, zoals het gebruik van beeldherkenning in productielijnen om kwaliteitscontrole uit te voeren, het gebruik van optimalisatie modellen voor een efficiëntere verdeling van middelen/capaciteit of het analyseren van gegevens om nauwkeurige voorspellingen te doen. Al deze oplossingen hebben hun eigen risico's, maar ook veel voordelen. Vooral als het gaat om grote hoeveelheden gegevens, zal AI veel efficiënter zijn dan mensen. Houd echter wel goed rekening met informatiebeveiliging, tevredenheid van je collega’s en klanten en duurzaamheid bij het beoordelen van de risico's van je nieuwe AI-oplossing.

welkom oplossing